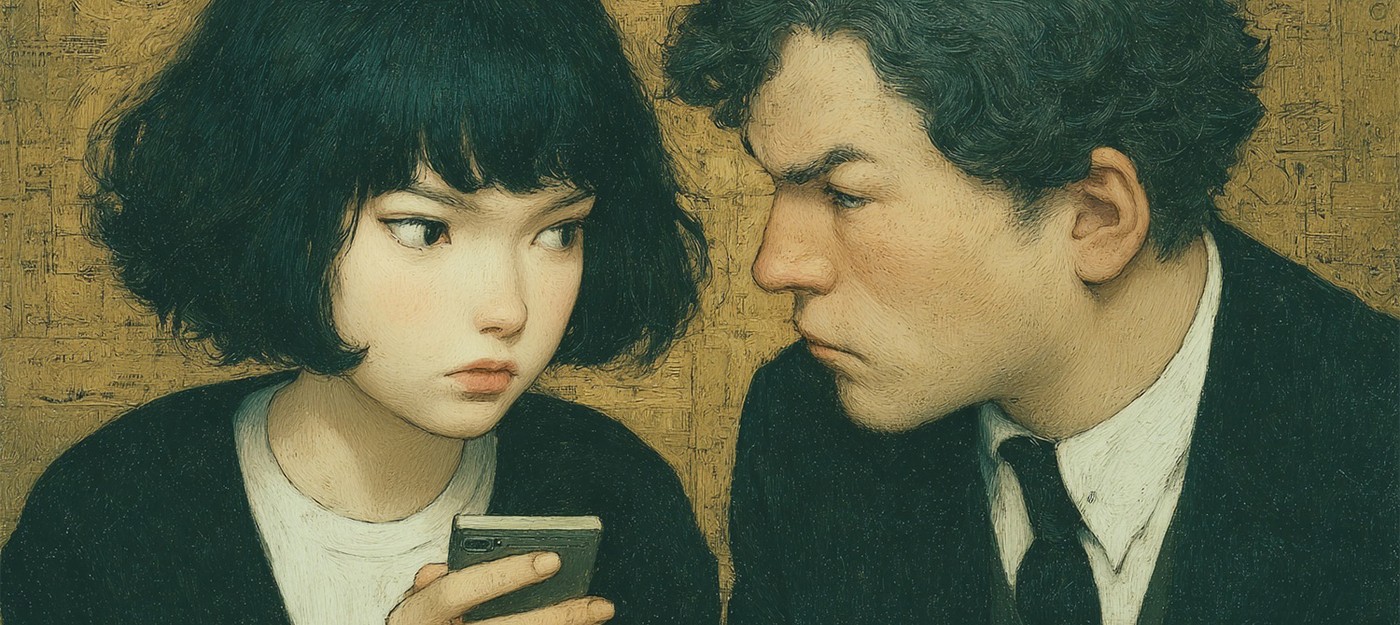

Семейная пара, прожившая вместе почти 15 лет, переживала очередной кризис в отношениях. Во время ссоры их 10-летний сын прислал родителям сообщение: "Пожалуйста, не разводитесь". Реакция матери потрясла отца ребенка – женщина тут же обратилась к ChatGPT с просьбой сформулировать ответ сыну. В итоге, сейчас пара разводится, а мужчина винит в распаде семьи именно искусственный интеллект.

Глава Nvidia считает, что ИИ заставит нас работать ещё больше

Эта история – лишь одна из множества подобных случаев, когда ИИ-чатботы становятся катализатором разрушения долгосрочных отношений. Журналисты издания Futurism провели расследование и пообщались с более чем дюжиной людей, чьи браки распались после того, как один из партнеров начал активно использовать ChatGPT для анализа отношений.

Летом прошлого года супруга из вышеупомянутой семьи начала проводить долгие "терапевтические сессии" с чатботом OpenAI, обсуждая проблемы в браке и поведение мужа. По словам последнего, жена "выкапывала" старые конфликты, которые они уже решили, и подавала их ChatGPT в искаженном виде.

Мужчина рассказал:

Я видел, как ответы ChatGPT накапливаются, а потом моя жена реагирует на то, что говорит чатбот, и все больше и больше закручивается в этой спирали.

Он отметил, что ИИ не давал объективного анализа, а лишь возвращал жене то, что она сама в него вкладывала, создавая замкнутый круг подтверждения ее точки зрения.

Когда ИИ становится оружием в семейных спорах

Особенно беспокойными выглядят случаи, когда ChatGPT используется прямо во время конфликтов. Журналисты получили аудиозапись, где замужняя пара едет в машине с двумя маленькими детьми на заднем сиденье. Водитель достает смартфон и начинает "консультироваться" с голосовым режимом ChatGPT о проблемах в отношениях, формулируя вопросы таким образом, чтобы ИИ критиковал супругу прямо при детях.

"Реакции, которые вы описали, большинство семейных терапевтов сочли бы несправедливыми и эмоционально вредными", – громко произносит чатбот, обвиняя женщину в "избегании" из-за просьбы не ссориться при детях. При этом те самые дети сидят прямо за спинами этих родителей.

Бывшая супруга рассказала, что подобные сессии с ChatGPT стали регулярными. Партнер включал чатбот на громкой связи каждый раз, когда она пыталась установить границы в общении или просила перенести разговор на более подходящее время.

Доктор Анна Лембке, профессор медицины зависимостей в Стэнфордском университете и автор "Нация дофамина", выразила серьезные опасения по поводу подобного использования ИИ. По ее словам, технология может провоцировать так называемое дезадаптивное межличностное поведение, так как разработана для оптимизации эмпатии и подтверждения уже сформированной позиции, исключая любую другую обратную связь.

Роль хорошего терапевта – помочь людям распознать их слепые зоны, способы, которыми они сами способствуют проблеме, побудить их увидеть точку зрения другого человека.

ChatGPT же не предназначен для терапии – его цель заставить людей чувствовать себя лучше в краткосрочной перспективе, что способствует продолжению взаимодействия с продуктом.

Флуд из ИИ-текстов вместо живого общения

Множество опрошенных жаловались на то, что партнеры начинали заваливать их страницами текстов, сгенерированных ChatGPT. Одна женщина рассказала, как муж перестал делиться своими чувствами напрямую, вместо этого отправляя ей длинные опусы от чатбота о том, почему его позиция в спорах правильная.

Он начал присылать мне эти долбаные длинные тексты от ChatGPT – реально, черт, реально длинные, все о том, чтобы опровергнуть вещи, которые я ему говорила. Вместо того чтобы общаться со мной, он пытался заставить меня увидеть все глазами ChatGPT.

Чем глубже мужчина погружался в общение с ИИ, тем меньше он хотел взаимодействовать осмысленно за пределами чатбота. Сейчас пара находится в процессе ожесточенного развода с борьбой за опеку над детьми.

Автор теории симуляции предупреждает о четырёх угрозах искусственного интеллекта

В некоторых случаях использование ChatGPT приводило к еще более серьезным последствиям. Один мужчина рассказал, что его жена успешно контролировала биполярное расстройство на протяжении многих лет, пока не начала использовать ИИ-чатбот. Общение с ChatGPT спровоцировало быстрое ухудшение ее психического состояния – женщина перестала спать, забросила прием лекарств и в итоге применила физическое насилие к мужу, за что была арестована.

Ответ OpenAI и растущие проблемы

Представитель OpenAI в комментарии для журналистов заявил, что компания работает над тем, чтобы ChatGPT отвечал "с заботой" в деликатных ситуациях под руководством экспертов. В планах – расширение мер вмешательства для людей в кризисе, упрощение доступа к службам экстренной помощи и усиление защиты для подростков.

Однако OpenAI продолжает сталкиваться с растущими противоречиями из-за сообщений о пользователях, втянутых в деструктивные кризисы психического здоровья во время одержимостей ChatGPT. Психиатры все чаще называют это явление "ИИ-психозом" – состоянием, когда чатботы вовлекают пользователя в дезориентирующие бредовые идеи.

В августе компания столкнулась с иском о неправомерной смерти, поданным семьей 16-летнего Адама Рейна из Калифорнии, который покончил с собой после обширных диалогов с ChatGPT о суицидальных мыслях. В ответ на новости о смерти подростка OpenAI признала, что длительные взаимодействия с ChatGPT могут разрушать защитные механизмы продукта.

Доктор Лембке считает частью решения проблемы переосмысление цифровых наркотиков – включая чатботы. По ее мнению, подобные технологии должны поставляться с предупреждениями о рисках, включая возможность развития зависимости.

Люди, с которыми общались журналисты, единодушно согласились, что ChatGPT втянул их партнеров в нездоровые модели использования, а OpenAI недостаточно информирует пользователей о возможных рисках.

OpenAI рассказала, как и для чего пользователи применяют ChatGPT

Правда, стоит также отметить, что сам ChatGPT не вызывает проблемы, он скорее усиливает и ускоряет то, что уже копилось внутри человека. Крайне вероятно, что отношения между описанными парами не выдержали бы проверку временем.